【エンジニア 情報収集】Google Developers ML Summit Tokyo : Human-Centered Machine Learning

今回は2019.09.18に六本木ヒルズのGoogle日本オフィスで開催された機械学習系のカンファレンス、Google Developers ML Summit Tokyo : Human-Centered Machine Learning(Google Developers ML Summit vol4)のメモです。

コンセプトはUX × ML

・ユーザ体験

・MLプロジェクトの社会性

・AIの倫理

人にうれしいAIのためのUXデザインガイド

http://storywriter.jp/pair/

質問はこちらまで

https://app.sli.do/event/yxyohhgl/live/questions

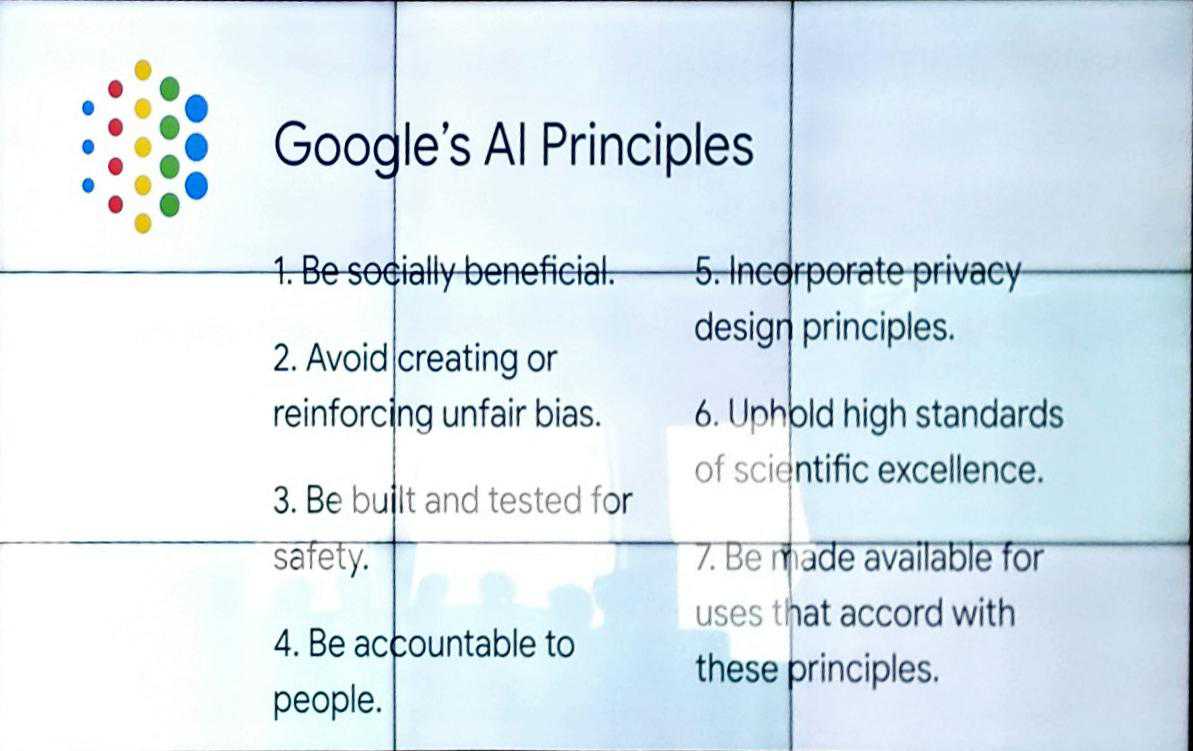

Socially Responsible AI

Andrew氏

色補正による肌色の色味の問題

黒人が黒くなりすぎる。白人は白くなりすぎる

顔検出器

黒人の顔を認識しなかった

データセットに肌の濃い人の写真を使っていなかった

再犯者推定アルゴリズム

Deep Learningアルゴリズムで再犯者を指定

正しく再犯者を推定することができなかった

再犯率が低いと判定された人が再犯を犯し

再犯率が高いと判定された人が再犯を犯さなかった

画像をDeep Learningしたところで、犯罪者を推定できるわけがない

その背景情報を加味する必要がある

性的嗜好推定アルゴリズム

Deep Learningをするよりも、アンケート調査による投擲の方が制度が高かった

AI、機械学習は使い方を誤ると、バイアスまみれの概念を世の中にばら撒くことになってしまう。

→ 相関をとるだけで、因果関係をとることはできない

もの検出アルゴリズムの孕むバイアス

途上国の固形石鹸を食べ物として認識

先進国の石鹸の画像を学習したモデルを、途上国で利用できない

サブグループに分けて評価していくと精度が上がる

Fairness and Explainability in ML

Kaz Sato, Developer Advocate

Data is your code

PFN 丸山氏提唱 : 帰納的プログラミング

https://www.slideshare.net/pfi/20180305ppl2018

Fairness ML

ありとあらゆる性別、国籍に対応するサービスを作る必要がある

がんの画像はそのまま利用できない

→ つまみの標準化が必要。医師ごとにつまみの位置が異なる

→ データクレンジグが大切

AIを使ったサービスを作る上で学んだこと

・ターゲット人口全てを代表するニュアンスを汲んだ、学習と評価を

・評価漏れをユーザよりも先に知る

・データは生鮮食品

Design ML

機械学習のモデルで対応できない問題はUXの改善で対応

Googleの取り組み:Data Card , Model Cardを準備することで、データの公平性維持の努力

ユーザに対してAIがそう決断を下したのかを客観的に説明するには?

判断をブラックボックス化せず、なぜそういう判断をしたのか

What-if Tool

AIのFairness(公平性)を定量的に判断するツール

TensorBoard等から利用可能

https://pair-code.github.io/what-if-tool/

Explainability Tool

Designing Human-Centered AI Products

Di Dang

Emerging Tech Design Advocate

人にうれしいAIのためのデザインガイド

http://storywriter.jp/pair/

People + AI Research (PAIR)

https://ai.google/research/teams/brain/pair

False-Positive(偽陽性)とFalse-Negative(偽陰性)の評価が重要

AIの結果を人間がどう解釈、判定するか

Mental Model

ユーザの視点を理解する

どうやってユーザのメンタルモデルを理解して、製品に落とし込むか

Triptech

Surveys validate the need

Feedback

Implicit Feedback

Explicit Feedback

feedbackを得ても結果に影響を与えるものでなければ、ユーザビリティは向上しない。

ML Kit × Material Design

ML Kit

Object Detection

Sensing

Recognizing

Communicationg

Barcode Scaning

To summarize ...

3 principles

1.Make camera UI minimal and meanignful

2. keep users informed at every moment

3. Anticipate opportunities for issues

Resources

AI Transparency

Andrew

What Does AI Transparency Mean?

・accountability

説明責任

・empowerment

制御 etc…

・explainability

説明

・remediation

AIは間違うので、常に改善が必要になる

AIの透明性を確保するには、上記が満たされる必要がある

Data sourceを選択するのはわれわれ。

つまり、AIによってもたらされるartifactのみならず、そのsourceの管理も重要

Benefit of Transparent Data & Model Reporting

Q&A

Q

公平性を担保する、バイアスを排除するのは理想ですが、適切なデータセットを用意したり、1%以下の事象のために無限のコストをかけられるわけではありません。また1%以下の事象に対応するために99%の事象の精度が下がってしまうのも得策ではありません。精度とコスト、その割合やバランスについてどのような考えをお持ちでしょうか?

A

文脈による。たとえば1%が100万人に及ぶような重要なものならば、1%に対してコストをかけることもあります。

UIで対応する方法もあります

Q

What metrics can we use for fairness/explainability?

A

何がメトリクスとして使えるのではなく、何が意味をなすのかです。われわれの製品の宣伝ではないですが、それらを利用してみてください。

Q

データを見れないとき(Privacyなどの理由で)、What-IFなどの解析をどうすればいいでしょうか?

A

暗号化し、個人がわからない形で解析をすることがあります。Privacyのほうが優先順位が高いのはしようがないことです。

Q

車載向けのプロダクトなどで安全上の理由などから選択肢を出して選ばせるのが難しい場合、ユーザーに対してはどのように伝えるのが良いなどといった。スマホ以外のUXに関するガイドラインやベストプラクティスなどはないでしょうか?

A

メンタルモデルの利用等、なんらかの方法でその他の解決策を探るしかありません

Q

私達はGoogleのように世界中から大規模のデータを生み出すことが出来る仕組みを持っていません。限られたデータセットを元にシステムを構築する場合、そこにバイアスがあるかどうかすら分からない事もあると思います。私達はそのような時にバイアスがある可能性に気がつくためにどのようなことが出来ますか?

A

個人や小規模の企業が仕組みを構築するのが難しいことはわれわれも問題意識として持っています。バイアスがあるのは問題ではなく、バイアスが差別につながることが問題です。モデルのパフォーマンスをモニターし、試してみて、問題があれば絶えずイテレーションをまわして改善していくしかありません。

Q

小さなチーム、2~3名のチームでPeople + AI Guidebookを実践するのはとても大変なように思いました。Googleでは何名でPJに取り掛かり、どれくらいでリリースできたでしょうか?

A

みなさんのユースケースに特化したものを開発しなければならない。なので、リソースは限られていてもよいと思います。われわれがやっていることは前提の構築です。ですので、あなた方の課題を整理する必要があります。

われわれのつくったガイドブックを利用してください。それは小さなチームにとっても非常に有用なものであるという実績があります。

いちどで完璧なものを作るのではなく、イテレーションを回して絶えない改善をしていきましょう。

Q

MLの公平性、説明可能性については Google に限らず競合他社(Amazon, Microsoft, Apple ,...)も同じように重要課題と捉えて取り組んでいるのでしょうか?

A

はい。Partner Ship AIをしらべてみてください。

Q

営利企業においてデータの透明性(データカードやデータモデル)の作成活動をするにはどのようなアプローチがあるでしょうか? MLのプロジェクトメンバーをdata transparencyに関する情報の提供者の時間を割くのは、直接、売り上げに貢献するわけではないので簡単ではないです。

A

まずは少しずつドキュメント化をすすめましょう。いずれそれが発展すればその必要性が出てくるはずです。金銭的価値もうまれるはずです。たとえばエンジニアの方々はわかるはずです。説明のないコードは誰からも理解されず、それは利用されなくなるということを。おっしゃっていることはわかります。ドキュメント化には手間がかかるのは重々承知です。

しかしながら、まずはドキュメント化からはじめましょう。

Q

ML の結果が伝わるデザインにするために、どれくらいの期間や何回デザインの試行、ML チームとの調整をされましたか?

A

およそ4ヵ月ほどだったとおもいます。インフォーマルなテストも行い、できるだけチームの人からフィードバックをもらいました。

Q

ガンの診断に病院にある画像では明るさとかが統一されていないからデータとして使えないという話でしたが、ラベルを設定しても使えないものなのでしょうか

A

Human Radar:トレーニングセットのラベルに責任を持つ人たち。彼ら向けにトレーニングセットをチューニングしたものをセットして、精度をあげるという方法もあるかもしれません。

まとめ

機械学習(AI)の技術が発展するほどに、そのアーティファクトの倫理性、公平性が問われるようになるというお話でした。多くの学習データをもとに作ったモデルには、多分にその作成元の認識バイアスが含まれるという問題があります。

興味深かった紹介事例として、たとえば先進国の石鹸はボトルに入ったものが標準的で、途上国の石鹸は固形石鹸であるようです。先進国の石鹸の認識しかもたない人がそれを識別する画像認識のモデルを作ると、途上国の石鹸は何か食べ物として認識されたということです。機械学習(AI)とは魔法ではなく、いわば数理統計的手法のひとつなので、それを理解せずに何事も機械学習で解決しようとすると「機械学習の濫用」となり、問題解決のアプローチとして不適切かつ、的を射ない結果しか得られません。いわゆる相関関係と因果関係をはき違えるという誤謬に陥ることがあります。

Deep Learningアルゴリズムの発明により近年一気に発展を遂げている機械学習(AI)ですが、人間が誤りを犯すのと同様、構築した統計モデルでは対応しきれない事象がこの世には多分に存在することを理解しなければなりません。同時に、多様性が叫ばれる昨今ですが、この技術の普及は改めて倫理性、公平性について再考せよ、という人類に対するある種の示唆のようにも思います。

以上